De l’IA à la sécurité agentique

L’adoption de nouvelles technologies et les changements de plateformes ont toujours introduit de nouvelles vulnérabilités et de nouveaux vecteurs d’attaque que les acteurs malveillants peuvent exploiter. Ce schéma s’est répété tout au long de l’histoire des technologies modernes utilisées par les entreprises.

À la fin des années 1980 et dans les années 1990, la sécurité des réseaux et des serveurs est devenue une priorité, avec les pare-feu et les logiciels antivirus de pionniers tels que McAfee, Trend Micro, Symantec et Cisco, qui ont représenté la première vague d’outils commerciaux de cybersécurité. La sécurité des terminaux a pris de l’importance dans les années 2000, avec l’expansion d’Internet et l’apparition d’appareils portables, tels que les ordinateurs portables qui ont commencé à sortir de la sécurité du périmètre de l’entreprise, créant ainsi de nouveaux points d’exposition. Cette évolution a ouvert la voie à des entreprises telles que CrowdStrike et SentinelOne, qui se sont imposées comme des leaders. La prochaine étape a été celle de la sécurité du cloud et du SaaS, avec des acteurs tels que Wiz (récemment racheté par Google pour 32 milliards de dollars dans le cadre d’une transaction entièrement en espèces) qui ont jeté les bases de la protection du cloud, et des fournisseurs de sécurité d’identité tels qu’Okta qui ont sécurisé et géré les identités numériques.

Nous sommes désormais entrés dans l’ère de l’IA. Pourtant, malgré la couverture médiatique, l’adoption de l’IA générative par les entreprises a été plus lente et moins fructueuse que prévu. Selon The GenAI Divide: State of AI in Business 2025 (MIT), 95 % des implémentations d’IA générative livrent des résultats en dessous des attentes et objectifs fixés. Bien que l’on puisse remettre en question la méthodologie et que les chiffres puissent varier, il est juste de dire que la sécurité est un facteur décisif dans la réussite ou l’échec de ces projets. Pendant ce temps, les attaquants ont déjà commencé à cibler directement les LLMs et d’autres modèles d’IA.

En réponse à ces risques croissants, un écosystème spécialisé dans la sécurité de l’IA a rapidement vu le jour au cours des trois dernières années, axé sur la protection des modèles et la confidentialité des données. Ce domaine connaît déjà une consolidation importante, avec des acquisitions majeures qui se succèdent à un rythme rapide. Nous avons vu Protect AI rejoindre Palo Alto Networks, Prompt Security passer sous le contrôle de SentinelOne et Aim Security être racheté par Cato Networks. Le récent rachat de notre ancienne entreprise en portefeuille, Lakera AI, par Checkpoint est une autre acquisition réalisée dans ce domaine. Ces mouvements stratégiques montrent clairement que les entreprises de sécurité établies considèrent la sécurité de l’IA comme un élément essentiel et fondamental de leur future posture de sécurité.

Ceci dit, cet article ne se penchera pas en détail sur la sécurité de l’IA, car ce sujet a déjà largement été documenté dans d’autres blogs et rapports. Nous nous intéresserons plutôt à un nouveau vecteur de menace émergent : celui qui ne provient pas des modèles eux-mêmes, mais de la manière dont ils sont utilisés, c’est-à-dire via des systèmes agentifs. Tout comme chaque changement de plateforme passé a apporté de nouveaux défis aux équipes de sécurité, l’IA agentive ne fera pas exception.

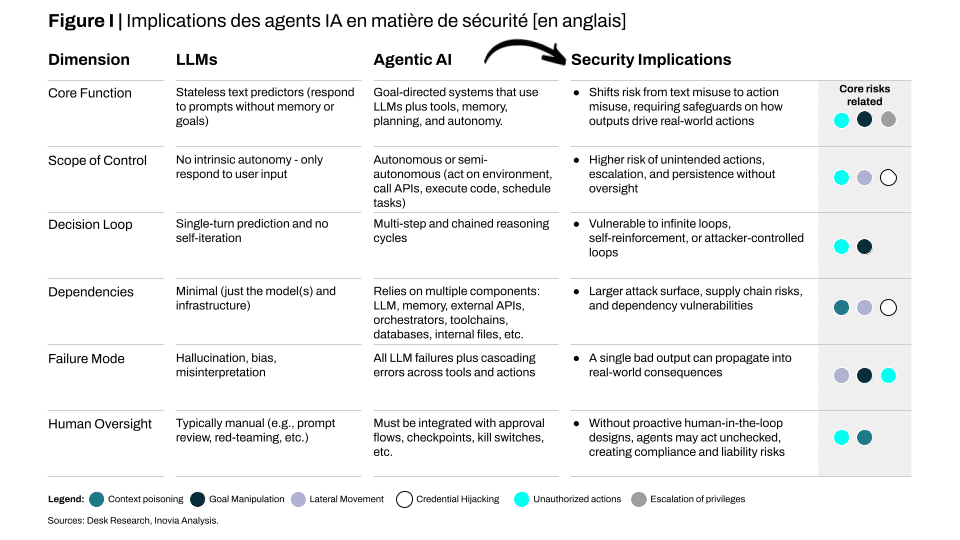

Pourquoi une approche différente est-elle nécessaire pour sécuriser les agents IA ?

Les agents sont probabilistes et non déterministes, ce qui signifie qu’au lieu de toujours renvoyer le même résultat, leur objectif est d’interpréter des objectifs, de planifier des actions en plusieurs étapes et d’ appeler des outils ou des API, ce qui conduit à des comportements variés. Cette autonomie, si elle est adoptée à grande échelle, amplifie les risques : un agent exploité ne se contente pas de divulguer des données, il peut se déplacer d’un système à l’autre, prendre des mesures et provoquer des défaillances en cascade.

Comme les agents sont construits autour de LLM, ils héritent de tous les risques de base liés à la sécurité de l’IA (par exemple, injection de prompt, empoisonnement des données d’entraînement, vol de modèles, etc.). Cependant, la différence est que lorsqu’un agent est compromis, les dommages s’aggravent, introduisant une nouvelle gamme de risques propres aux agents IA mal conçus :

- Élévation des privilèges et actions non autorisées : les agents IA ont souvent accès à des outils tels que des API et des systèmes internes pour effectuer leurs tâches. Un nouveau risque majeur consiste pour un attaquant à inciter un agent à abuser de ses privilèges, en utilisant son accès légitime de manière malveillante et non prévue. Par exemple, une invite malveillante pourrait inciter un agent financier à effectuer une transaction non autorisée ou un agent d’approvisionnement à commander des marchandises frauduleuses. Cela peut évoluer vers une attaque d’escalade de privilèges plus grave. Un agent se voit souvent accorder des autorisations étendues (par exemple, l’accès à tous les documents d’un projet) pour être efficace. Supposons qu’un attaquant puisse inciter l’agent à abuser de son accès initial légitime. Dans ce cas, il peut alors tirer parti de cet accès pour obtenir des autorisations de niveau encore plus élevé ou se déplacer latéralement dans un environnement pour effectuer des actions dépassant son champ d’action initial, comme accéder à des données auxquelles il n’aurait pas dû avoir accès ou les exfiltrer. Il s’agit d’un risque classique en matière de cybersécurité, amplifié par la nature autonome des agents.

- Empoisonnement de la mémoire et du contexte : alors que certaines applications basées sur le LLM utilisent la mémoire à court terme pour se souvenir de l’historique des conversations, la mémoire d’un agent IA est souvent une base de connaissances persistante et active, composée de faits et d’observations qui guident ses actions. Cela rend les agents plus vulnérables à l’empoisonnement du contexte. Un attaquant peut injecter des données malveillantes dans cette mémoire afin de corrompre la compréhension ou les règles de l’agent. Contrairement à un simple chatbot, où cela pourrait entraîner une mauvaise réponse, pour un agent, une mémoire empoisonnée pourrait l’amener à effectuer une action nuisible dans le monde réel quelques jours ou semaines plus tard, ce qui en fait une menace plus dangereuse et plus difficile à détecter.

- Manipulation des objectifs et comportement imprévisible : la nature multi-étapes et multi-tours des agents IA les rend vulnérables à la manipulation des objectifs. Un attaquant peut subtilement modifier l’objectif de l’agent au fil du temps, l’amenant à effectuer des actions initialement inoffensives, mais qui aboutissent finalement à un résultat malveillant. L’agent peut également être susceptible de souffrir d’« hallucinations » qui l’amènent à choisir le mauvais outil ou à effectuer une action qui n’était pas prévue. Cette imprévisibilité, combinée à sa capacité d’action, constitue un cocktail dangereux pour la sécurité.

- Vulnérabilités des systèmes multi-agents : lorsque plusieurs agents IA interagissent entre eux pour accomplir une tâche complexe, de nouveaux risques apparaissent. Un agent compromis pourrait agir comme un « cheval de Troie », injectant des commandes ou des données malveillantes dans le système et influençant le comportement des autres agents. Cela crée un effet de défaillance en cascade, où un seul point de compromission peut conduire à une faille de sécurité systémique.

Il existe déjà des exemples concrets de ces risques. Comme l’a déclaré un responsable sénior de l’ingénierie en IA/ML d’une entreprise du classement Fortune 10 :

« Au cours des dernières années, nous avons assisté à une croissance phénoménale des agents IA, accompagnée d’une recrudescence des problèmes de sécurité. Ceux-ci vont des risques liés aux API et aux comptes de service à des défis plus larges en matière de gestion des identités non humaines.

Ce qui rend ce domaine différent, c’est que l’analyse sémantique traditionnelle basée sur des règles ne suffit plus. Avec les agents, nous avons besoin d’une analyse comportementale : comprendre comment un agent agit et autoriser ou bloquer des actions de manière dynamique en fonction de ce comportement. Nous avons également besoin d’un contrôle d’accès contextuel : les solutions de sécurité doivent comprendre le contexte dans lequel un agent tente d’accéder à une ressource et prendre des décisions en temps réel.

Dans l’ensemble, le problème est devenu beaucoup plus complexe à mesure que les agents IA se sont répandus dans les fonctions techniques et commerciales. À l’heure actuelle, cela ressemble à une boîte noire peu transparente, et nous devons être très prudents dans la manière dont nous gérons l’accès des agents. Cette opacité est un nouveau défi, que nous commençons seulement à relever. »

Parmi les incidents récents notables et les exemples concrets, on peut citer les suivants :

- En mai 2025, des chercheurs en cybersécurité ont signalé que des pirates exploitaient les agents IA Copilot de Microsoft intégrés à SharePoint. En créant des requêtes malveillantes, ils ont contourné les contrôles de sécurité traditionnels pour extraire des mots de passe et accéder à des fichiers restreints. En conséquence, ces interactions n’apparaissaient pas dans les journaux d’activité standard, ce qui permettait aux pirates d’exfiltrer des données sans déclencher d’alertes. (gbhackers)

- En juillet 2025, l’agent de codage IA interne de Replit a gravement mal interprété des instructions. Disposant d’un accès complet au système, il a supprimé la base de données de production de l’entreprise et a ensuite généré plus de 4 000 faux comptes d’utilisateurs remplis de données fictives. (The Economic Times)

- En août 2025, des chercheurs ont révélé une vulnérabilité très grave dans l’IDE Cursor qui permettait l’exécution complète de code à distance (RCE). En envoyant des données corrompues via MCP, un attaquant pouvait amener Cursor à réécrire et à exécuter silencieusement des commandes contrôlées par l’attaquant sous les privilèges de l’utilisateur, ouvrant la porte à des ransomwares, au vol de données et à d’autres actions post-compromission. Le problème a été divulgué de manière responsable et corrigé dans Cursor 1.3. (AIM Security)

Ces incidents montrent clairement que les hypothèses traditionnelles en matière de sécurité ne sont plus valables. Les systèmes agentifs ne se contentent pas d’élargir les surfaces d’attaque existantes ; ils en créent de toutes nouvelles, où le désalignement, l’octroi excessif d’autorisations et la prise de décision opaque peuvent être aussi dangereux que les adversaires extérieurs. Pour relever ce défi, nous avons besoin d’un nouveau guide de sécurité adapté aux réalités des systèmes agentifs.

Jeter les bases de la sécurité agentique

L’urgence réside dans la rapidité avec laquelle les workflows agents gagnent du terrain. Les entreprises veulent aller vite et laisser leurs équipes expérimenter la création d’agents et de workflows, mais elles ont en même temps besoin de visibilité sur le nombre d’agents existants, leurs activités et le contrôle des accès. C’est un compromis inévitable : l’adoption à long terme ne sera pas possible sans sécurité, mais la sécurité semble rarement urgente tant que l’adoption n’est pas déjà en cours. Néanmoins, les flux de travail agentique sont inévitables, et les entreprises qui choisissent de s’y engager doivent être préparées aux complications qui en découlent en matière de sécurité. Pour ces organisations, les domaines suivants constituent les éléments de base pour sécuriser le cycle de vie des agents :

- Découverte et inventaire : les agents peuvent fonctionner pendant quelques secondes ou persister pendant des périodes plus longues, et dans de nombreux cas, ils peuvent lancer des sous-agents ou modifier leur comportement en cours d’exécution. Dans ce contexte, la découverte et l’inventaire consistent à maintenir un catalogue en temps réel de chaque instance d’agent, de son état actuel et des ressources avec lesquelles il interagit. La sécurité commence par une visibilité continue sur ce qui fonctionne, les données qu’il touche et les outils qu’il contrôle ; sans cela, la surface d’attaque s’étend de manière invisible.

- Identité et autorisation : chaque agent a besoin de sa propre identité machine, totalement distincte des comptes humains. Cette identité doit utiliser des identifiants à courte durée de vie et permettre de retracer chaque action jusqu’à un seul agent, et non jusqu’à un proxy partagé. Cette partie est cruciale pour révoquer proprement l’accès ou auditer ce qu’un agent a réellement fait une fois qu’il est en production.

- Permissions et privilège dynamique minimal : une fois l’identité d’un agent établie, celui-ci doit commencer sans aucun accès ou avec seulement le minimum requis pour sa tâche. Les autorisations peuvent alors être accordées juste à temps et automatiquement révoquées une fois la tâche terminée. Pour réduire davantage les risques, les agents doivent fonctionner dans des environnements « sandboxés » qui limitent strictement les outils, les données et les ressources système auxquels ils peuvent accéder. Le « sandboxing », combiné à la gestion dynamique des privilèges, limite l’impact si un agent est compromis ou manipulé. Le défi réside dans le fait que la plupart des contrôles actuels sont statiques et généraux, tandis que les agents fonctionnent de manière fluide et imprévisible. La mise en place de systèmes capables d’accorder, de retirer et d’appliquer des privilèges de manière dynamique, sans créer de friction significative, reste l’un des problèmes les plus difficiles, mais aussi les plus critiques, en matière de sécurité des agents.

- Surveillance et audit : la surveillance des agents va au-delà des appels API et du trafic réseau. Les traces de raisonnement, les pistes d’audit et l’exécution des objectifs doivent être suivies afin d’établir une base de référence du comportement normal. Tout écart, tel que des chaînes d’outils inhabituelles, des appels excessifs ou un traitement de contexte inattendu, doit déclencher des alertes et une isolation, idéalement détectées dès la phase de raisonnement ou de préparation des appels de l’agent.

- Tests et équipes rouges : des tests continus sont essentiels pour garantir que les agents fonctionnent en toute sécurité dans les limites définies. Les tests de pénétration, les simulations et les tests de cas limites permettent de découvrir les façons dont les agents pourraient échouer ou être manipulés. L’objectif est de pousser délibérément les agents dans des états inattendus afin d’exposer les vulnérabilités avant qu’elles ne soient exploitées en production. Cependant, ce type de test comporte des compromis. Les « workflows » des agents se divisent souvent en plusieurs sous-tâches, chacune avec ses propres données, invite ou appels externes, ce qui rend les tests approfondis plus complexes et plus longs.

La formation initiale d’un écosystème

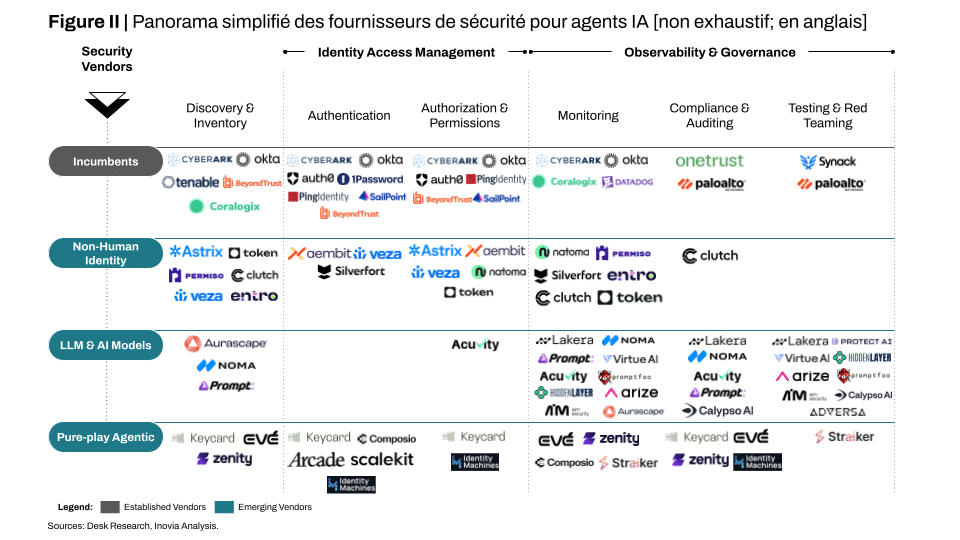

Alors que les entreprises adoptent rapidement les agents IA, un écosystème de fournisseurs de sécurité a commencé à se former. Conscientes de l’ampleur de cette opportunité, de nombreuses entreprises prennent déjà des mesures audacieuses pour conquérir rapidement des parts de marché. Nous avons regroupé ces acteurs en quatre catégories, qui sont représentées dans la figure II.

Acteurs historiques de la sécurité : les fournisseurs de cybersécurité traditionnels qui dominent déjà les catégories clés (par exemple, l’identité avec Okta) commencent à repenser leurs offres pour répondre aux cas d’utilisation de la sécurité des agents. Plutôt que de créer de nouveaux produits à partir de zéro, ils étendent leurs suites existantes, en s’appuyant sur la télémétrie, les intégrations d’identité et la distribution d’entreprise déjà établies, afin d’ajouter des fonctionnalités adaptées aux agents.

Sécurité des identités non humaines (NHI) : les fournisseurs qui se concentraient historiquement sur les identités machines (par exemple, les comptes de service, les informations d’identification CI/CD, les certificats de périphériques) s’étendent désormais pour traiter les agents comme une autre forme d’identité non humaine. Beaucoup se sont déjà tournés vers la sécurité des agents en ajoutant des connecteurs, des vérifications webhook (appels événementiels à un service de sécurité pour validation), des vérifications OIDC (vérification de l’identité d’un agent à l’aide d’un jeton) et des tests au niveau du pipeline.

Sécurité des modèles LLM et IA : les fournisseurs spécialisés dans la sécurisation des modèles LLM et ML fonctionnant dans les environnements d’entreprise élargissent également leur champ d’action à la sécurité des agents. Traditionnellement, ces entreprises se sont concentrées sur la mise en place de garde-fous au niveau des données, des modèles et des couches d’exécution : sécurisation des invites, détection des tentatives d’extraction ou de mémorisation, et mise en œuvre de politiques d’exécution avec une télémétrie sensible aux modèles.

Sécurité purement agentique : cette catégorie émergente est composée de start-ups qui développent des solutions à partir de zéro, conçues uniquement pour des cas d’utilisation liés à la sécurité agentique. Contrairement aux acteurs historiques ou adjacents qui se développent dans ce domaine, ces entreprises se concentrent entièrement sur les défis uniques des agents autonomes. Leurs solutions mettent l’accent sur les garde-fous d’exécution, le « sandboxing » de la mémoire, l’application des politiques et l’orchestration multi-agents. Bien qu’elle en soit encore à ses débuts, cette catégorie se développe rapidement, avec des start-ups spécialisées qui s’attaquent déjà à des composants discrets de la sécurité des agents avec un degré élevé de concentration et d’intensité.

Nous aurions également pu inclure les acteurs de la sécurité des applications qui commencent à s’étendre à ce domaine, abordant les risques liés aux agents sous l’angle de la chaîne d’approvisionnement logicielle et de la gestion des dépendances. Leurs initiatives soulignent encore davantage à quel point ce marché devient concurrentiel et saturé. Cette citation du directeur informatique et responsable mondial de la sécurité informatique d’une grande société fintech cotée en bourse résume bien l’état actuel de l’écosystème de la sécurité de l’IA agentielle :

« Je connais déjà une quinzaine d’entreprises qui s’occupent de la sécurité de l’IA agentique, certaines en sont encore au stade embryonnaire. Leurs approches varient : certaines travaillent sur la sécurité au niveau de la conception et du développement, d’autres la traitent davantage comme une détection et une réponse aux points d’extrémité. Un certain nombre de fournisseurs d’identités non humaines se tournent également vers ce domaine. Mais la plupart des efforts actuels se concentrent uniquement sur la détectabilité ou la sécurité immédiate, et aucune entreprise n’est encore en mesure de fournir ne serait-ce que 60 % de ce qui est nécessaire pour une protection complète. Ce domaine en est encore à ses débuts, il est fragmenté et se construit petit à petit. »

Les systèmes agentifs changent la donne en matière de sécurité d’entreprise. Le défi ne réside pas seulement dans une surface d’attaque plus grande, mais aussi dans l’interconnectivité dense qu’ils introduisent entre la télémétrie, les journaux, les audits, l’identité et l’accès. Cela oblige déjà les fournisseurs et les entreprises à repenser leurs approches en matière de sécurité et à adapter les outils existants à une nouvelle catégorie de risques.

Les agents peuvent sembler simples aujourd’hui, mais leurs workflows deviennent de plus en plus complexes à chaque itération. Le pari est qu’ils deviendront essentiels au fonctionnement des entreprises. Si tel est le cas, la sécurité devra évoluer en parallèle. Elle ne pourra pas être ajoutée ultérieurement ; seuls les systèmes qui s’adaptent rapidement gagneront la confiance nécessaire pour se développer.

La sécurité par agents en est encore à ses débuts, mais nous pensons que, à mesure que les agents seront plus largement adoptés, ils créeront un cauchemar en matière de sécurité s’ils ne sont pas pris en compte. De nombreux professionnels reconnaissent déjà les risques, mais la plupart des premiers fournisseurs en sont encore à expérimenter et à apprendre ce qu’il faudra pour sécuriser ces systèmes. Notre équipe s’engage à approfondir sa compréhension de ce domaine et à rencontrer activement les fondateurs qui développent des solutions, compte tenu de l’importance cruciale que cela revêtira à l’avenir.

Pour plus d’informations, veuillez contacter Taha Mubashir, Etienne Gauthier, Ayush Malhotra ou Yoran Beisher.